第33卷第4期 辽宁石油化工大学学报 Vol .33 No .420 13年 12月JOURNAL OF LIAONING SHIHUA UNIVERSITYDec . 2 0 13文章编号 :16 72 桘 69 52( 2 013)04 桘 0 08 3 桘 0 4基 于 迭 代 学 习 的 BP 神 经 网 络 权 值 训 练 算 法周小勇 ,翟春艳 ,李书臣( 辽宁石油化工大学信息与控制工程学院 ,辽宁营口 1130 01)倡多层神经网络bp算法权值更新过程,苏成利摘 要 : 针对传统 BP 算法存在收敛速率过慢 、易深陷局部极小的问题 , 提出基于迭代学习的 BP 神经网路残差修正算法 。 该算法将迭代学习的原理与神经网路相结合 , 同 时采用 本次训 练偏差和前一次的训练偏差修正神经网路残差 , 提高了网路训练速率 。 仿真结果验证了该算法的有效性 。关键词 : 神经网路 ; 梯度算法 ; 迭代学习型算法 ; 权值训练 ; 收敛速率中图分类号 : TP183 文献标志码 :A doi :10.3 69 6/ j .issn .167 2 桘 6 95 2 .20 13 .0 4.0 20Weight Training Algorithm of BP NeuralNetwork Based on Iterative LearningZHOU Xiaoyong ,ZHAI Chunyan多层神经网络bp算法权值更新过程,LI Shuchen( College of Information and Control Engineering , LiaoningShihua University, Fushun Liaoning1130 0 1 , China)倡, SU ChengliReceived 9 January2 013 ; revised 10 April 2 013 ; accepted 10 September 2 013Abstract : A weight training algorithm of neural network based on iterative learning was proposed for the shortcoming oftraditional BP algorithm ,such as slow convergence and easily trapped into local minimal . The algorithm combined the principleof iterative learning with neural network ,and it made use of the current and the previous training error to correct the neuralnetwork weights .It improved the speed of neural network training .Simulation results show the effectiveness of the algorithm .Key words : Neural network ; Gradient algorithm ; Iterative learning algorithm ; Weight training ;Convergence speed倡 Corresponding author . Tel . :+8 6 ‐15 2 4132 9 35 3 ; e‐mail :Lishuchen@yeah .net BP 神经网路采用梯度下降算法 ,用仅富含一个蕴涵层能够以任意精度迫近任何连续非线性函[ 1], 对于它的研究除了在理论方面取得了明显的数进展 , 在实际应用方面也较为成熟 。

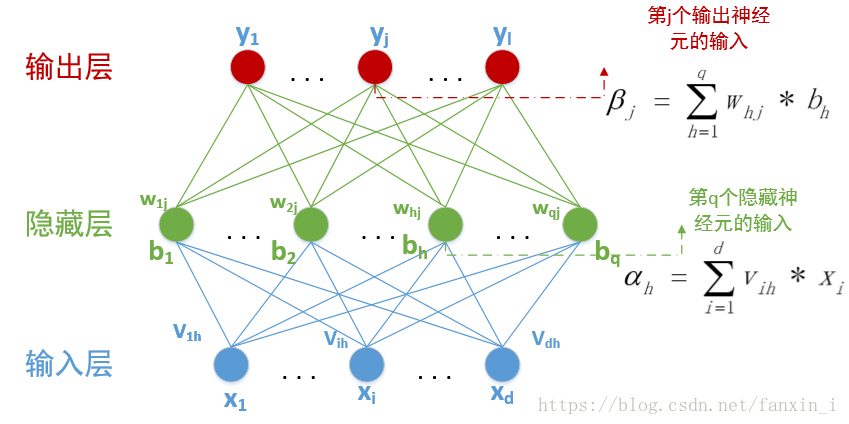

由于梯度下降算法是根据均方误差的梯度增长方向收敛的 ,该算[ 2],一是容易让神经网路残差学法存在着两点问题习深陷局部极小 ,二是这些算法修正残差时没有考虑各个样本之间的耦合关系 。 为此 ,近年来好多新的 BP 神经网路残差训练算法不断地被提出[ 3‐ 5]。 神经网路采用样本数据进行网路训练的过程 ,实质上就是网路联接残差不断更新以达到理想网路残差的过程 。 网络残差的修正 ,是用每次训练后网路的输出偏差以迭代的方式去反复修正 ,而迭代学习 控制十分适用于具有重复运行特点的被控系统 ,收稿日期 :2 0 13 ‐0 1‐ 09作者简介 :周小勇( 19 8 6 ‐) , 男 , 湖北襄阳市 , 在读硕士 。基金项目 :辽宁省科技攻关项目 ( 20 112 16 011) 。倡 通信联系人 。通过输出偏差不断去修正输入控制量 。 修正后的控制量使被控系统的实际输出轨迹在规定的时间内就能完全跟踪期望输出轨迹 ,实现输出偏差基本趋近[ 6], 以此考虑用迭代学习控制的原理去改进网于零络的常规训练算法[ 7‐ 11]。 对于神经网路残差训练算法的研究 ,绝大多数研究是从针对函数梯度的启发式学习算法和基于数值最优化理论训练算法两个方向去改进 ,本文则从网路的训练样本之间的耦合关系上入手 ,考虑采用本次训练偏差和前一次的训练偏差 ,即用两个样本集的偏差信息去更改残差 , 提出迭代学习型的神经网路残差训练算法 。1 迭代学习型神经网路算法1 . 1 传统 BP 算法BP 神经网路是一种基于偏差的反向传播多层卷积式网路 , 通常采用三层结构 ,包括输入层 、隐含层和输出层 。 网络中相邻层的神经元之间有连结 ,称之为网路连结残差 。 BP 神经网路须要先输入学