从2018年的BERT,到2020年的GPT-3,再到如今爆火的chatGPT,自然语言处理(NLP)技术的快速发展,而且不断突破原有的界限。作为NLP研究人员/爱好者来说,及时地了解NLP最新技术就变得至关重要。因此,明天给你们分享10篇2023年2月的顶尖NLP论文,其中主要包括:语言模型、训练优化、模型功击、多模态推理、文本生成识别等最新进展,相信看完你对目前NLP技术发展有一个更新的认识!

10篇文章获取,回复:2023开年顶尖论文

Toolformer

当前预训练语言模型非常牛,它们只需几个示例或文本说明就可以解决新任务。但是,它们在简单的物理运算、事实查找等基本功能上却表现不佳。怎样将这三者结合上去呢?这么就是接出来要介绍的Toolformer!

Toolformer是一个模型,可以通过简单的API自学使用外部工具。经过训练,可以决定调用什么API、何时调用它们、传递什么参数以及怎样最好地将结果合并到未来的Token预测中。它采用自监督的方法实现该功能,只须要为每位API进行少量演示。

Toolformer包含一系列工具,包括估算器、问答系统、两个不同的搜索引擎、翻译系统和月历。最好重要的是它在零样本情况下,在不牺牲其核心语言能力的情况下,在各类下游任务中都实现了急剧提高,并可比拟更大的模型。Toolformer将语言模型与软件工具的应用结合,未来能否让我们的生活显得愈发轻松。

SWARM并行性

在本文中,作者解决了训练具有数十亿参数的小型深度学习模型的问题,众所周知,这须要价位高昂的专用HPC集群。为了解决这个限制,本文探求了训练这种小型模型的取代训练方式,比如使用廉价的实例或汇集来自多个区域的资源。

之后,它剖析了现有模型并行算法在这种条件下的性能表现,确定了训练小型模型时通讯密集度增加的配置。因此引入了SWARM并行性,这是一种新颖的模型并行训练算法,专为联接不良、异构和不可靠的设备而设计。

「SWARM在节点之间创建临时随机管线,在发生故障时重新平衡这种管线,这是对现有大规模训练方式的重大改进」。作者依据经验验证了她们的发觉,并将SWARM并行性与现有方式进行了比较。

为了进一步展示本文方式的优势,本文将自己的看法与压缩策略相结合,在高于200Mb/s网路的占领式T4GPU上训练具有1B共享参数(共享前大概13B)的小型Transformer语言模型。实验结果表现,SWARM并行性有可能彻底改变小型模型的训练方法,使研究人员和从业者等人更容易获得并具有成本效益。

符合人类偏好

在本文中,作者深入研究语言模型(LM)以及怎样训练它们生成符合人类偏好的文本。其实LM被预先编程为模仿互联网文本,这可能会造成一些不良结果。并且,「如果可以教LM生成连贯、信息丰富、符合人类偏好的文本呢」?

为解决这个问题,作者对预训练LM的五个目标进行了基准测试,并在三个任务中提供了人类反馈。研究了这种目标怎样影响预训练LM的对齐和能力之间的平衡。发觉了一种Pareto-optimal方式:条件训练。

条件训练主要是教LM学习按照它们的人类偏好分数(由奖励模型给出)在Tokens上的分布。得到的结果出奇的好,条件训练将不良内容的发生率增加了一个数目级,无论是在没有提示的情况下生成还是在对抗性选择的提示下生成时。

据悉,条件训练在任务特定微调之前和以后都保持了标准LM预训练的下游任务性能。与标准LM预训练相比,使用人工反馈进行预训练的偏好满意度要高得多,之后按照反馈进行微调。

总体而言,结果表明,在预训练LM时,它应当赶超模仿学习,并从训练开始就列入人类的偏好。这是确保语言模型生成符合人类偏好的文本的一大进步,见到这项技术在未来的发展方向令人激动!

多模态思维链

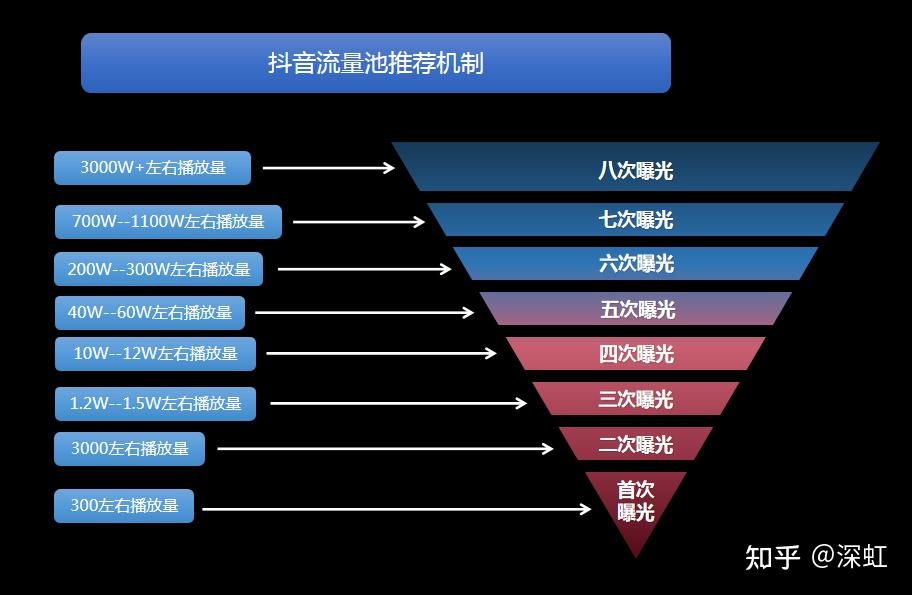

在本文中,作者介绍了「一种突破性的小型语言模型(LLM)新方式,该方式结合了文本和视觉以实现更好的推理性能」。这个新模型被称为Multimodal-CoT,它构建在思维链(CoT)方式的基础上,以生成中间推理链作为推测答案的基本原理。最大的不同之处在于快手热门算法,这一次,该模型将语言和视觉(图象)模式合并到一个两阶段框架中,将基本原理生成和答案推测分开。

多模态CoT模型致力借助基于多模态信息实现结果生成的基本原理,进而提升答案推测的确切性。结果不言自明:具有不到1亿个参数的模型在ScienceQA基准上比原先最先进的LLM(GPT-3.5)高出16个百分点(75.17%至91.68%的确切率),甚至超过了人类的表现。

Multimodal-CoT的代码在Github(github.com/amazon-science/mm-cot?ref=context-by-cohere)上公开可用,因而,倘若您有兴趣探求这项尖端技术,只需单击一下即可。通过这个新模型,作者在开发小型语言模型和多模态推理方面迈出了重要的一步快手热门算法,为人工智能和机器学习领域更令人激动的进步铺平了公路。

模型病毒功击

在本文中,作者深入研究了深度学习模型中数据集中毒功击的危险。这种功击将恶意示例引入到模型的性能中,这可能会形成严重的后果。作者介绍了「两种新的实用功击,可以残害10个流行的数据集」。

第一种功击是分屏视图中毒,它借助了互联网内容的易变特点。通过操纵注释者对数据集的视图,她们可以引入恶意示例,而后续顾客端不会注意到这种恶意示例。这些功击尤其狡诈,由于它借助了无效的信任假定。令人惊讶的是,作者发觉她们只需60港元就可以残害0.01%的LAION-400M或COYO-700M数据集。

第二种功击是“前沿中毒”(frontrunningpoisoning),目标是网路规模的数据集,这种数据集定期对众包内容进行快照,例如维基百科(Wikipedia)。功击者只须要一个有时间限制的窗口就可以将恶意示例注入数据集。

针对那些功击,作者通知了每位受影响数据集的维护者,并推荐了几种低开支的防御举措。这种防御举措将有助于减少数据集中毒的风险,并保护深度学习模型免受恶意功击。

优化算法发觉

在本文中,作者介绍了一种新的算法发觉方式,将其框定为程序搜索。她们应用这些方式来「发现深度神经网路训练的优化算法」,并演示了它怎样消弭代理任务和目标任务之间的泛化差别。

她们的方式借助有效的搜索技术来探求无限和稀疏的程序空间。为了简化流程,她们还引入了课程选择和简化策略。她们的方式的结果是发觉了一种新的优化算法,Lion(进化符号动量)。

与Adam和Adafactor等广泛使用的优化器相比,Lion的显存效率更高,由于它只跟踪动量。它与自适应优化器的另一个不同之处在于,它的更新对于通过符号操作估算的每位参数具有相同的大小。

作者在各类模型和任务上测试了Lion,并表明它在几个学习领域上都优于Adam,包括图象分类和扩散模型。在个别情况下,Lion还须要更小的学习率,由于符号函数形成的更新的范数更大。但是,作者也承认了Lion的局限性,并强调了其改进很小或在统计上不明显的情况。它们将Lion的实现公开地提供给其他人使用和重构。